Kevin Dietsch/Getty Images

- Die künstliche Intelligenz von Facebook entfernt weniger als 5 % der Hassreden, die auf der Social-Media-Plattform angesehen werden.

- Ein neuer Bericht des Wall Street Journal beschreibt Mängel in der Strategie der Plattform, schädliche Inhalte zu entfernen.

- Facebook-Whistleblower Frances Haugen sagte, das Unternehmen verlasse sich gefährlich auf KI und Algorithmen.

Facebook behauptet, dass es künstliche Intelligenz verwendet, um Beiträge mit Hassreden und Gewalt zu identifizieren und zu entfernen, aber die Technologie funktioniert laut internen Dokumenten, die vom Wall Street Journal überprüft wurden, nicht wirklich.

Die leitenden Ingenieure von Facebook sagen, dass das automatisierte System des Unternehmens nur Beiträge entfernt hat, die nur 2% der auf der Plattform angesehenen Hassreden generiert haben, die gegen ihre Regeln verstoßen, berichtete das Journal am Sonntag. Eine andere Gruppe von Facebook-Mitarbeitern kam zu einem ähnlichen Ergebnis und sagte, dass die KI von Facebook nur Beiträge entfernt habe, die 3 bis 5 % der Hassreden auf der Plattform generierten und 0,6 % der Inhalte, die gegen die Gewaltregeln von Facebook verstießen.

Der Sonntagsbericht des Journals war das neueste Kapitel in seinen “Facebook-Dateien”, in dem festgestellt wurde, dass das Unternehmen seine Auswirkungen auf alles von der psychischen Gesundheit junger Mädchen, die Instagram nutzen, bis hin zu Fehlinformationen, Menschenhandel und Bandengewalt auf der Website ignoriert. Das Unternehmen hat die Berichte als “Fehlcharakterisierungen” bezeichnet.

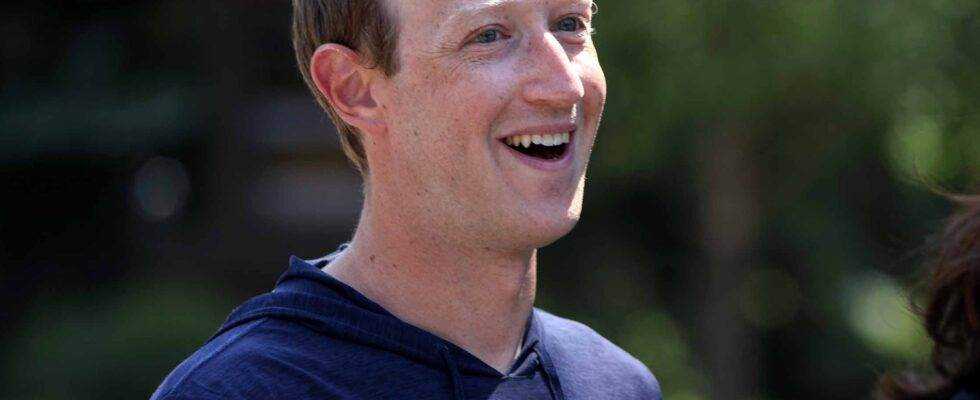

Facebook-Chef Mark Zuckerberg sagte, er glaube, dass die KI von Facebook laut dem Journal „die überwiegende Mehrheit der problematischen Inhalte“ vor 2020 entfernen könnte. Facebook steht zu seiner Behauptung, dass die meisten Hassreden und gewalttätigen Inhalte auf der Plattform verbreitet werden von seiner “supereffizienten” KI abgehängt bevor Benutzer es überhaupt sehen. Facebooks Bericht vom Februar dieses Jahres behauptete, dass diese Erkennungsrate über 97% liege.

Einige Gruppen, darunter Bürgerrechtsorganisationen und Akademiker, stehen den Statistiken von Facebook weiterhin skeptisch gegenüber, da die Zahlen der sozialen Plattform nicht mit externen Studien übereinstimmen, berichtete das Journal.

“Sie werden ihre Arbeit nie zeigen”, sagte Rashad Robinson, Präsident der Bürgerrechtsgruppe Color of Change, dem Journal. „Wir fragen, was ist der Zähler? Was ist der Nenner?

Facebooks Chef für Integrität, Guy Rosen, sagte dem Journal, dass die von ihm überprüften Dokumente zwar nicht auf dem neuesten Stand seien, die Informationen jedoch Facebooks Entscheidungen über die KI-gesteuerte Inhaltsmoderation beeinflusst hätten. Rosen sagte, es sei wichtiger zu sehen, wie Hassreden auf Facebook insgesamt schrumpfen.

Facebook reagierte nicht sofort auf die Bitte von Insider, einen Kommentar abzugeben.

Die neuesten Ergebnisse des Journals stammen auch, nachdem sich die ehemalige Facebook-Mitarbeiterin und Whistleblowerin Frances Haugen letzte Woche mit dem Kongress getroffen hatte, um zu diskutieren, wie sich die Social-Media-Plattform zu stark auf KI und Algorithmen verlässt. Da Facebook Algorithmen verwendet, um zu entscheiden, welche Inhalte seinen Nutzern gezeigt werden sollen, sind die Inhalte, mit denen Facebook am meisten interessiert ist und die Facebook anschließend versucht, seinen Nutzern zu übermitteln, normalerweise wütende, spaltende, sensationslüsterne Posts, die Fehlinformationen enthalten, sagte Haugen.

„Wir sollten Software haben, die auf den Menschen zugeschnitten ist, bei der Menschen miteinander Gespräche führen, und nicht Computer, die es ermöglichen, von wem wir hören können“, sagte Haugen während der Anhörung.

Die Algorithmen von Facebook können manchmal Schwierigkeiten haben, zu bestimmen, was Hassrede und was Gewalt ist, was dazu führt, dass schädliche Videos und Posts zu lange auf der Plattform verbleiben. Facebook hat fast 6,7 Millionen organisierte Hassinhalte von seinen Plattformen entfernt Oktober bis Dezember 2020. Laut einem Bericht des Journals betrafen einige entfernte Posts Organverkauf, Pornografie und Waffengewalt.

Einige Inhalte, die von seinen Systemen übersehen werden können, umfassen jedoch gewalttätige Videos und Rekrutierungsbeiträge, die von Personen geteilt werden, die an Bandengewalt, Menschenhandel und Drogenkartellen beteiligt sind.