Facebook hat ein neues Forschungsprojekt namens Ego4D angekündigt, das darauf abzielt, KI-Modelle mithilfe von Videos zu trainieren, die aus einer menschlichen Perspektive aufgenommen wurden, und dann mithilfe von Augmented-Reality-Hinweisen durch den Zugriff auf das Protokoll vergangener Aufzeichnungen eine Anleitung zu geben. Das neueste KI-zentrierte Forschungsprojekt des Social-Media-Riesen stellt die Computer-Vision-Technologie in den Mittelpunkt, die bereits teilweise für Produkte wie Google Lens und eine Handvoll anderer Shopping-Tools verwendet wird, bei denen ein Bild untersucht wird, um ähnliche Einträge aus e -Handelsplattformen.

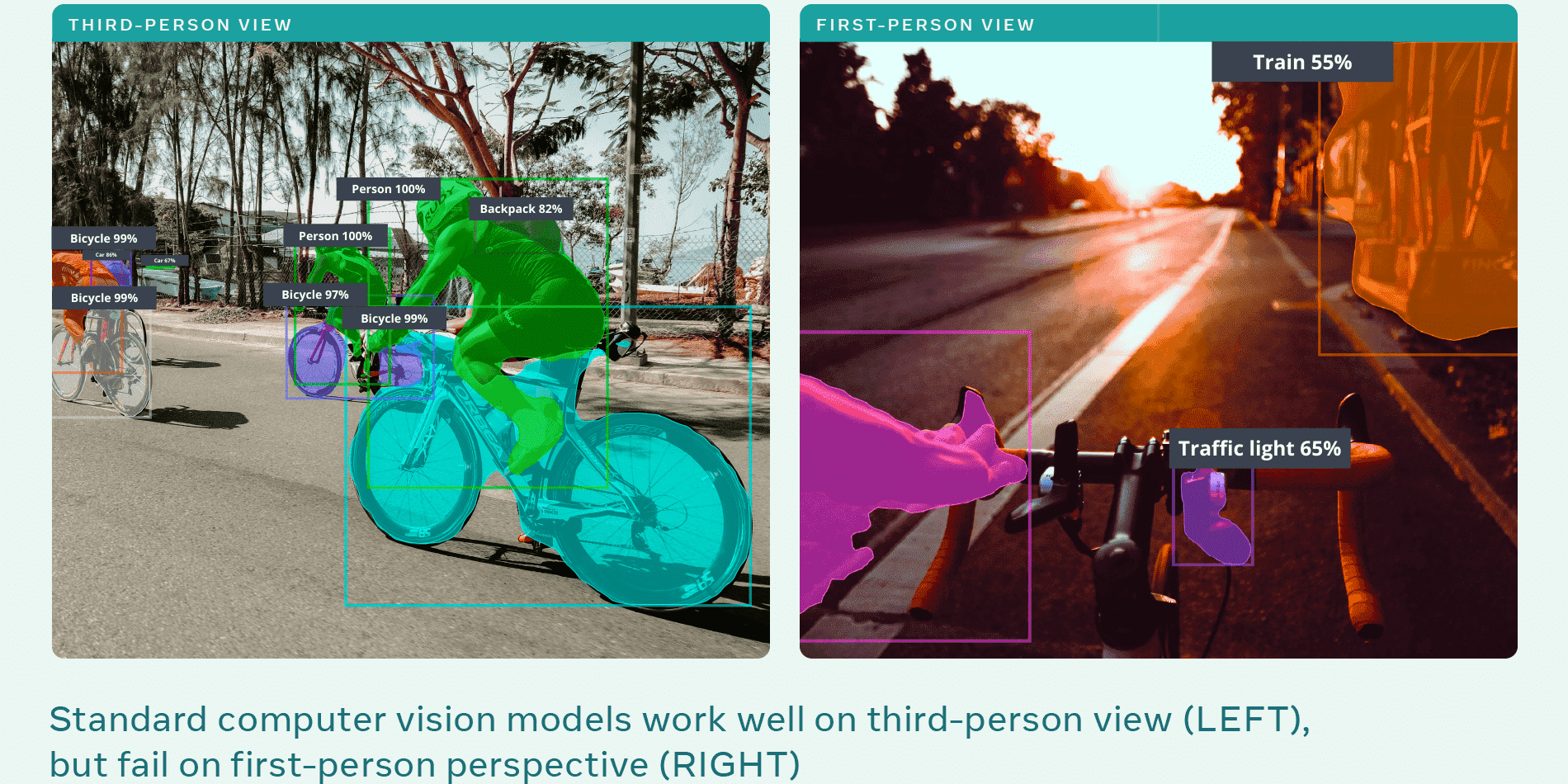

Das Unternehmen hat kürzlich seine Arbeit an neuen KI-gestützten visuellen Such- und Produkterkennungstools detailliert beschrieben, die das Einkaufserlebnis auf Instagram verbessern werden. Auf der Straße werden Online-Listen von Kleidungsstücken aufgerufen, indem einfach auf das Foto einer Person getippt wird. Das hauseigene Produkterkennungssystem ist so ausgereift, dass es selbst bei vagen textbasierten Abfragen wie „Finde ein Hemd mit ähnlichem Polka-Dot-Muster“ auf seinen Plattformen relevante Produkte aufruft. Aber all diese Objekterkennungssysteme basieren überwiegend auf einem Computer-Vision-System, das auf Fotos und Videos trainiert wird, die aus der Perspektive einer dritten Person aufgenommen wurden.

Facebook geht noch einen Schritt weiter, indem es die Perspektive der Trainingsdaten von der Seitenlinie direkt in die Mitte des Geschehens mit einer First-Person-Perspektive als Teil seiner Ego4D-KI ändert Projekt. Die Möglichkeiten scheinen endlos vorteilhaft und auch ein wenig beängstigend zu sein. Um die Trainingsdaten zu sammeln, hat Facebook mit 13 Institutionen in neun Ländern zusammengearbeitet, die über 700 Teilnehmer rekrutierten, um mehr als 2.200 Stunden Ego-Filmmaterial aufzunehmen, das alltägliche Aktivitäten wie Lebensmitteleinkauf, Waschutensilien und Schlagzeugspielen dokumentiert. ein paar. Ziel ist es, die Aktivitäten festzuhalten und das Szenario auch aus der eigenen Perspektive einer Person zu bewerten, ähnlich wie die Aktion, die von der Facebook-eigenen Ray-Ban Stories-Sonnenbrille aufgezeichnet wird.

Das Unternehmen nennt es egozentrische Wahrnehmung, daher der Name Ego4D. Das Video wurde transkribiert und mit Anmerkungen versehen, um alles im Rahmen von einem Objekt bis zur Aktion zu beschreiben, um einen Datensatz zu erstellen, den Forscher auf der ganzen Welt verwenden können, um Computer-Vision-Systeme zu entwickeln und eine neue Welle der KI-Entwicklung zu katalysieren. Wendy hat sich kürzlich mit Google Cloud zusammengetan, um ein solches Computer-Vision-System zu entwickeln, das die Küche überwacht und den Koch benachrichtigt, wenn es Zeit ist, Burger zu wenden. Das Ego4D-Projekt von Facebook gibt jedoch diesen KI-Funktionen eine AR-Drehung, die weit über die Analyse hinausgehen und tatsächlich in den Bereich der Vorhersage der Aktionen der Benutzer eintreten.

Dazu hat Facebook ein Set von fünf Benchmarks gezaubert, die eine egozentrische Wahrnehmungs-KI erreichen muss. Das erste ist das episodische Gedächtnis, das genauso funktioniert wie das menschliche Gedächtnis. Wenn Benutzer beispielsweise vergessen, wo sie die TV-Fernbedienung platziert haben, greift die KI auf vergangene Ego-Videos zu, um zu überprüfen, wo die Benutzer sie abgelegt haben, und führt sie dann mithilfe von AR-Hinweisen wie Apple Maps zum Ort. Der zweite Benchmark ist die Prognose, die vorhersagt, was der Benutzer tun wird, und die notwendige Warnung liefert. Wenn also ein Benutzer seinem Curry bereits Pfeffer hinzugefügt hat und erneut nach der Pfefferpulverflasche greift, erkennt die KI die bevorstehende Aktion und warnt den Benutzer sofort, dass die Zutat bereits hinzugefügt wurde.

Ebenso die ‘Hand- und Objektmanipulation’ Benchmark möchte, dass sich die KI eine korrekte Abfolge von Ereignissen merkt, was den Schülern hilfreich ist, da AR-Hinweise ihnen die Schritte in einem aufgezeichneten Schulungsvideo zeigen. Der vierte Maßstab ist die soziale Interaktion, während der fünfte – und alarmierendste – ist Audiovisuelles Tagebuch. Dieser beinhaltet das Speichern eines Audio- (und möglicherweise auch textbasierten) Protokolls dessen, was eine Person im Blickfeld der Kamera gesagt hat. Benutzer können dann der KI Fragen stellen, beispielsweise was Person ABC an einem bestimmten Tag während ihrer Kaffeepause gesagt hat. Facebook hat die Sicherheitsvorkehrungen für die scheinbar massiven Szenarien des Eindringens in die Privatsphäre für sein Projekt noch nicht detailliert beschrieben. Die Ray-Ban-Geschichten wurden bereits wegen ihrer Fähigkeit, in den vollständigen Creep-Modus zu wechseln, auf den Prüfstand gestellt. Und mit einer so intelligenten KI wie Ego4D wird es viel mehr Sorgen um die Privatsphäre geben.

Positiv ist, dass das Ego4D-Projekt einen sehr deutlichen Eindruck davon vermittelt, was Facebook mit dem Metaverse erreichen möchte, zumindest wenn es darum geht, den Nutzern im täglichen Leben zu helfen. Und die starke Anwendung von Augmented Reality, um diese Ziele zu erreichen, ist ein Zeichen dafür, dass Facebook auf AR voll einsteigen wird und fortschrittlichere Wearables definitiv in der Pipeline sind. Aber die größte Frage ist, ob sich die Benutzer damit wohl fühlen werden Facebook angesichts der skizzenhaften Vergangenheit des Unternehmens mit Datenschutzskandalen einen persönlicheren Zugang zu ihrem Leben über Ego-Videos zu haben.

Quelle: Facebook