Wie das Unternehmen feststellt: „Seit den Anfängen der Suche hat uns die KI beim Sprachverständnis geholfen und die Ergebnisse hilfreicher gemacht. Im Laufe der Jahre haben wir unsere Investitionen in die KI vertieft und können jetzt Informationen in ihren vielen Formen verstehen – aus der Sprache vom Verstehen von Bildern zum Verstehen von Bildern, zum Verstehen von Videos und sogar zum Verstehen der realen Welt. Heute teilen wir einige neue Möglichkeiten, wie wir unsere Fortschritte in der KI anwenden, um das Erkunden von Informationen noch natürlicher und intuitiver zu gestalten.”

Google Lens durchsucht jetzt Ihren Bildschirm

Die erste Google-Funktion, über die wir sprechen werden, ist Google Lens, eine KI-gestützte Suchmaschine, die Ihre Fotos oder Live-Kameravorschauen anstelle von Wörtern verwendet. Lassen Sie sich überraschen? Lens wird jeden Monat über 10 Milliarden Mal verwendet. In den kommenden Monaten wird ein Update für Lens verbreitet, das es Android-Nutzern ermöglicht, „Ihren Bildschirm zu durchsuchen“. Nach dem Update können Sie mit Lens nach Fotos und Videos von Websites und Messaging- und Video-Apps suchen, ohne die App verlassen zu müssen. Cool.

Mit Google Lens können Android-Nutzer Fotos und Videos von Websites und Apps durchsuchen

Multisearch wird bald für lokale Suchen “in Ihrer Nähe” verfügbar sein

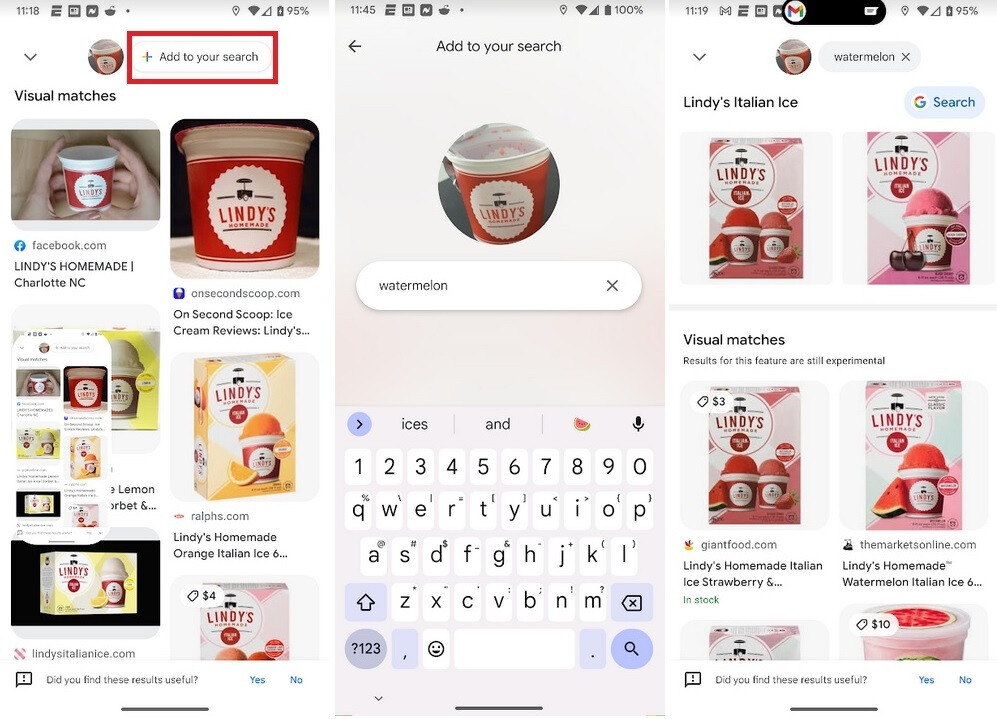

Nachdem Sie das Bild aufgenommen haben, werden die Ergebnisse teilweise unten auf dem Bildschirm angezeigt. Ziehen Sie den Tab-Halter nach oben und Sie sehen die Ergebnisse Ihrer Lens-Suche mit einer Schaltfläche oben, auf der „+Zu Ihrer Suche hinzufügen“ steht. Tippen Sie auf diese Schaltfläche und es erscheint ein Feld, in dem Sie Text hinzufügen können. In diesem Fall möchten wir Lindys Wassermeloneneis finden, also geben wir „watermelon“ ein und tippen auf das Lupensymbol unten rechts im QWERTZ (wo normalerweise „Enter“ steht) und Sie erhalten eine gezieltere Ergebnisseite .

Mit der Mehrfachsuche auf Google Lens können Sie Bilder und Texte zusammen durchsuchen

Multisearch ist weltweit auf Mobilgeräten und in allen Sprachen und Ländern verfügbar, in denen Sie die Google Lens-Funktion verwenden können. Aber du kannst jetzt lokal suchen, indem du die Wörter „in meiner Nähe“ zu einer Lens-Suche hinzufügst, um zu finden, was du in deiner Nähe haben möchtest. Diese Funktion ist ab sofort in englischer Sprache für US-Benutzer verfügbar und wird in den kommenden Monaten weltweit hinzugefügt. Und noch spannender: In den kommenden Monaten können Sie die Mehrfachsuche für jedes Bild verwenden, das auf der mobilen Google-Suchergebnisseite gefunden wird.