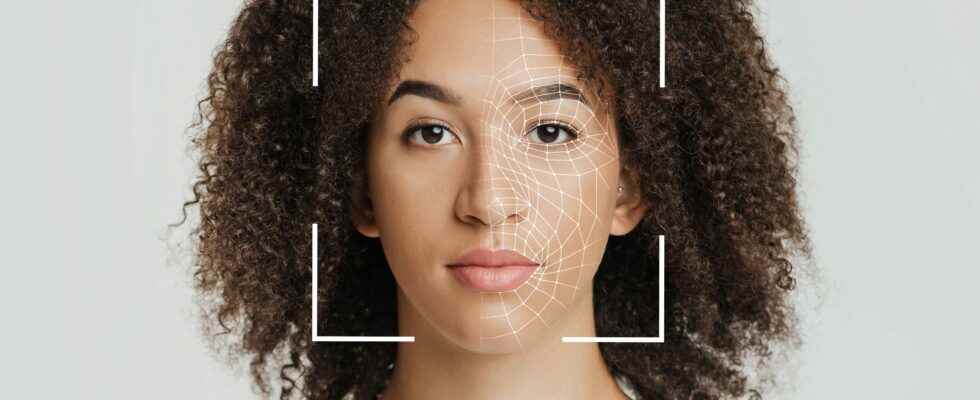

Getty Images

- Es ist bekannt, dass KI-Roboteralgorithmen rassistische und sexistische Stereotypen verwenden, wenn sie Menschen kategorisieren.

- Reale Anwendungen könnten Probleme für historisch marginalisierte Gruppen bedeuten, warnen Forscher.

- Kate Crawford, Autorin von „Atlas of AI“, diskutierte die Ethik der Kategorisierung von Menschen mithilfe von KI.

Die Zukunft gehört der künstlichen Intelligenz – zumindest laut der Tech-Industrie.

Während sich die Branche der Aussicht auf künstliche allgemeine Intelligenz nähert – oder KI, die die Fähigkeit hat, wie Menschen zu lernen und zu handeln – wird KI unter anderem zur Klassifizierung von Menschen eingesetzt. Unternehmen profitieren von der Technologie, um sie in allen Bereichen einzusetzen Überwachung zu den sozialen Medien.

Experten sagen jedoch, dass viele Ingenieure und Wissenschaftler mit fortschreitender KI immer noch den Schaden übersehen, den diese Algorithmen marginalisierten Gemeinschaften zufügen können.

Rassistische und sexistische Vorurteile existieren bereits in vielen der Algorithmen auf dem Marktsagten Experten zuvor gegenüber Insider, und es wird nicht genug getan, um die Branche zu regulieren.

In einem E-Mail-Interview mit Insider sagte Kate Crawford: KI-Forscher am USC Annenberg und Autor von „Atlas of AI“, ging auf die Risiken ein, sich auf KI zu verlassen, um Menschen zu klassifizieren.

Woher stammt die Idee, KI zur Klassifizierung von Menschen einzusetzen, und warum interessieren sich Unternehmen für den Einsatz dieser Technologie?

Die Verwendung von KI für Klassifizierungsaufgaben wie Emotionserkennung und die automatische Erkennung von Rasse, Geschlecht, Sexualität und sogar Kriminalität hat eine lange Geschichte, die Jahrzehnte zurückreicht. In meinem Buch „Atlas of AI“ gehe ich auf diese Geschichte ein, um nachzuzeichnen, wie Unternehmen diese Techniken in Kontexten wie Polizeiarbeit und gezielter Werbung eingesetzt haben. Es besteht jedoch kein wissenschaftlicher Konsens darüber, dass diese Ansätze überhaupt gültig sind. Menschen auf diese Weise zu klassifizieren geht davon aus, dass Geschlecht, Rasse und Sexualität biologisch und im Gesicht sichtbar sind. Das ist, wie wir wissen, einfach nicht wahr. Diese Ansätze basieren auf der Prämisse, dass Biologie Schicksal ist, wo unsere Gesichter zu unserem Schicksal werden. Ich nenne das einen „phrenologischen Impuls“ – den Wunsch, den Charakter von Menschen anhand ihres Aussehens zu kategorisieren.

Gibt es einen sicheren oder ethischen Weg, wie KI-Technologie zur Klassifizierung von Menschen eingesetzt werden kann?

Betrachten wir, was bei der Geschlechterklassifizierung passiert. Menschen in binäre Geschlechtskategorien zu reduzieren und Transgender-Personen unsichtbar oder „abweichend“ zu machen, sind gemeinsame Merkmale von Klassifizierungsschemata im maschinellen Lernen. Die Arbeit von Os Keyes über die automatische Geschlechtserkennung bei der Gesichtserkennung zeigt, dass 95 Prozent der Arbeiten auf diesem Gebiet das Geschlecht als binär behandeln, wobei die Mehrheit das Geschlecht als unveränderlich und physiologisch beschreibt. Dies steht im Widerspruch zu jahrzehntelanger Forschung, die zeigt, dass Geschlecht kulturell, relational und historisch ist. Während einige Unternehmen wie Facebook darauf reagierten, indem sie mehr als 50 Geschlechterkategorien erstellten, versäumten sie es, den tieferen Schaden anzugehen, der entsteht, wenn Menschen ohne ihre Zustimmung überhaupt in Geschlechts- oder Rassenkategorien eingeteilt werden.

Maschinelle Lernsysteme sind auf sehr reale Weise konstruieren Rasse und Geschlecht: Sie definieren die Welt innerhalb der von ihnen festgelegten Begriffe, und dies hat lang anhaltende Auswirkungen auf die klassifizierten Personen. Wenn solche Systeme als wissenschaftliche Innovationen zur Vorhersage von Identitäten gefeiert werden, beseitigt dies die technischen und ethischen Probleme, wie die Systeme aufgebaut wurden.

Die Frage hier ist also, warum macht man das überhaupt? Abgesehen von den ernsthaften ethischen Fragen ist die Klassifizierung des Geschlechts, der Rasse oder der Sexualität von Personen ohne deren Zustimmung oder Eingabe wahrscheinlich mit einer erheblichen Fehlerquote verbunden. Technische Systeme nehmen ideologische Eingriffe vor, wenn sie vereinfachende Bezeichnungen für etwas so Komplexes wie die persönliche Identität vergeben, und sie tun dies, indem sie eine Reihe von Möglichkeiten dessen, was es bedeutet, Mensch zu sein, reduzieren. Das schränkt die Bandbreite ein, wie Menschen repräsentiert und verstanden werden, was schwerwiegende Auswirkungen auf uns alle hat.

In Ihrem Buch sprechen Sie über die fragwürdige und manchmal unethische Art und Weise, wie Daten gesammelt und verwendet werden, um KI zu trainieren. Warum ist die KI-Industrie so unnachgiebig bei der Verwendung von Daten und Datenerfassungsmethoden, die nachweislich die Ungleichheit verschärfen?

Modelle für maschinelles Lernen erfordern kontinuierliche Datenflüsse, um genauer zu werden. Aber Maschinen sind asymptotisch und erreichen nie die volle Präzision, was die Rechtfertigung für mehr Datenextraktion von so vielen Menschen wie möglich vorantreibt. Dies hat zu einer Abkehr von Ideen wie individueller informierter Einwilligung oder ethischer Überprüfung der Forschung an menschlichen Probanden hin zur Schaffung von „betroffenen Subjekten“ geführt: Ansammlungen von Datenpunkten ohne Subjektivität oder Kontext oder klar definierte Rechte. Diese Art des Denkens hat eine Art ethische Distanz geschaffen und eine Kultur gefördert, in der Ingenieure nicht dafür belohnt werden, dass sie über die umfassendere Verantwortung für das, was sie bauen, nachdenken.

Glauben Sie, dass die KI-Industrie genug tut, um diese ethischen Probleme zu bekämpfen? Steht das Potenzial zur Entwicklung neuer Technologien der Umsetzung von Sicherheitsmaßnahmen im Weg?

Wenn sich herausstellt, dass KI-Systeme diskriminierende Ergebnisse in den Kategorien Rasse, Geschlecht oder Behinderung produzieren, verpflichten sich einige Unternehmen, ihre Tools zu reformieren oder ihre Daten zu diversifizieren. Das Ergebnis ist jedoch oft eine knappe technische Reaktion, normalerweise ein Versuch, technische Fehler und verzerrte Daten zu beheben, um das KI-System fairer erscheinen zu lassen. Es muss noch viel mehr getan werden, um die zugrunde liegende Logik der Verwendung automatisierter Klassifizierungen und die potenziellen Schäden, die dies verursachen kann, anzugehen.

Wie schätzen Sie das Verständnis der Menschen für diese Themen ein und wie können sie diese direkt beeinflussen? Sollte die breite Öffentlichkeit der KI-Branche mehr Aufmerksamkeit schenken?

Ich habe definitiv eine Zunahme des öffentlichen Bewusstseins in Bezug auf die Probleme der Voreingenommenheit und Klassifizierung in der KI festgestellt, aber was am dringendsten benötigt wird, sind regulatorische Maßnahmen. Einige Regierungsstellen wie der Rat der Europäischen Union, das britische Information Commissioner’s Office und die Federal Trade Commission unternehmen starke Schritte in Richtung Regulierung, aber wir müssen in vielen Ländern mehr Anstrengungen unternehmen, um sicherzustellen, dass die Menschen vor diesen Schäden geschützt sind.