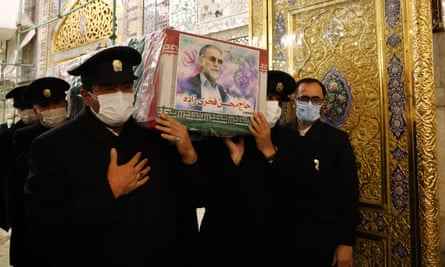

TDer Sicherheitskonvoi bog am 27. November 2020 gegen 15:30 Uhr auf den Imam Khomeini Boulevard in Teheran ein. Der VIP war der iranische Wissenschaftler Mohsen Fakhrizadeh, der weithin als Leiter des geheimen iranischen Atomwaffenprogramms angesehen wird. Er fuhr seine Frau zu ihrem Landgut, flankiert von Leibwächtern in anderen Fahrzeugen. Sie waren in der Nähe ihres Zuhauses, als der Attentäter zuschlug.

Mehrere Schüsse knallten in Fachrizadehs schwarzen Nissan und brachten ihn zum Stehen. Die Waffe feuerte erneut, traf den Wissenschaftler an der Schulter und veranlasste ihn, das Fahrzeug zu verlassen. Während Fakhrizadeh im Freien war, gab der Attentäter die tödlichen Schüsse ab und ließ Fakhrizadehs Frau unverletzt auf dem Beifahrersitz zurück.

Dann passierte etwas Seltsames. Ein am Straßenrand geparkter Kleintransporter explodierte ohne ersichtlichen Grund. Beim anschließenden Durchsuchen der Trümmer fanden die iranischen Sicherheitskräfte die Überreste eines Roboter-Maschinengewehrs mit mehreren Kameras und einem computergesteuerten Mechanismus zum Betätigen des Abzugs. War Fachrizadeh von einem Roboter getötet worden?

Anschließend Berichterstattung durch die New York Times ergab, dass das Roboter-Maschinengewehr nicht vollständig autonom war. Stattdessen wurde ein etwa 1.000 km entfernter Attentäter mit Bildern aus dem Lastwagen gefüttert und entschied, wann er abdrückt. Aber die KI-Software kompensierte die Bewegungen des Ziels in den 1,6 Sekunden, die es dauerte, bis die Bilder per Satellit vom Lastwagen an den Attentäter weitergeleitet wurden und das Signal zum Betätigen des Abzugs zurückkam.

Es ist der Stoff für Albträume, und Aufnahmen aus dem Krieg in der Ukraine tragen nicht dazu bei, die Ängste zu zerstreuen. Drohnen sind in dem Konflikt allgegenwärtig, von der in der Türkei hergestellten Bayraktar TB2, die verwendet wurde, um die russischen Besatzungstruppen auf Snake Island anzugreifen, über die Seedrohnen, die russische Schiffe im Hafen von Sewastopol angriffen, bis hin zu den modifizierten Quadrocoptern, die Granaten auf ahnungslose Infanterie und andere Ziele abwerfen. Und wenn man von Filmmaterial im Internet ausgeht, könnte es noch schlimmer kommen.

In einem Video auf Weibo gepostet, scheint ein chinesisches Rüstungsunternehmen eine Drohne zu präsentieren, die einen Roboterhund auf den Boden setzt. Der Roboter erwacht zum Leben. Auf seinem Rücken befindet sich ein Maschinengewehr. In einem anderen Video scheint ein im Handel erhältlicher Roboterhund von einer russischen Person modifiziert worden zu sein mit einer Waffe schießenwobei der Rückstoß den Roboter auf die Hinterbeine hebt.

Als Reaktion auf diese alarmierenden Videos reagierten im Oktober Boston Dynamics und fünf weitere Robotikunternehmen einen offenen Brief herausgegeben: „Wir glauben, dass das Hinzufügen von Waffen zu Robotern, die ferngesteuert oder autonom betrieben werden, der Öffentlichkeit weithin zugänglich sind und in der Lage sind, zu zuvor unzugänglichen Orten zu navigieren, an denen Menschen leben und arbeiten, neue Schadensrisiken und ernsthafte ethische Probleme aufwirft. Bewaffnete Anwendungen dieser neu fähigen Roboter werden auch das Vertrauen der Öffentlichkeit in die Technologie in einer Weise beeinträchtigen, die den enormen Nutzen, den sie der Gesellschaft bringen werden, beeinträchtigt.“

In einer Erklärung an die Beobachter, erklärte das Unternehmen weiter: „Wir haben eine Zunahme der provisorischen Bemühungen von Einzelpersonen gesehen, die versuchen, kommerziell erhältliche Roboter zu bewaffnen, und dieses Schreiben zeigt, dass die breitere Industrie der fortschrittlichen mobilen Robotik gegen die Bewaffnung ist und sich dafür einsetzt, dies zu vermeiden. Wir hoffen, dass die Stärke unserer Zahlen die politischen Entscheidungsträger ermutigen wird, sich mit diesem Thema zu befassen, um uns dabei zu helfen, die sichere Nutzung mobiler Roboter zu fördern und ihren Missbrauch zu verhindern.“

Boston Dynamics ist jedoch effektiv im Besitz der Hyundai Motor Group, die im Juni 2021 eine Mehrheitsbeteiligung an dem Unternehmen erworben hat, und ein anderer Teil dieser Gruppe, Hyundai Rotem, hat keine derartigen Bedenken. Im April dieses Jahres kündigte Hyundai Rotem eine Zusammenarbeit mit einer anderen südkoreanischen Firma, Rainbow Robotics, an, um mehrbeinige Verteidigungsroboter zu entwickeln. Eine Werbeillustration zeigt a Roboterhund mit einer Waffe angebracht.

Darüber hinaus fragt sich Verteidigungsanalyst und Militärhistoriker Tim Ripley, was das Engagement von Boston Dynamic in der Praxis bedeutet. Selbst wenn man diesen Robotern keine Waffen anschnallt, sagt er, können sie immer noch Kriegsinstrumente sein.

„Wenn der Roboter eine Überwachungsdrohne ist und ein Ziel findet und Sie eine Artilleriegranate darauf abfeuern und er Menschen tötet, dann ist diese Drohne genauso Teil eines Waffensystems wie eine Rakete auf der Drohne. Es ist immer noch ein Teil der Tötungskette“, sagt er.

Er weist darauf hin, dass die Drohnenüberwachung eine entscheidende Rolle im Ukraine-Krieg gespielt hat, die auf beiden Seiten eingesetzt wurde, um feindliche Bewegungen zu verfolgen und Ziele für Artillerie-Bombardierungen zu finden.

Wenn es um computergestützte militärische Hardware geht, gibt es immer zwei Teile des Systems: die Hardware selbst und die Steuerungssoftware. Während Roboter jenseits von Drohnen noch nicht alltäglich auf dem Schlachtfeld sind, findet immer mehr intelligente Software breite Anwendung.

„Es gibt eine ganze Reihe von Autonomiefunktionen, die bereits in unsere Systeme integriert sind. Es wurde als notwendig erachtet, weil es den Menschen ermöglicht, schnelle Entscheidungen zu treffen“, sagt Mike Martin, Senior War Studies Fellow am King’s College in London.

Er nennt das Beispiel eines Apache-Helikopters, der die Landschaft nach Wärmesignaturen absucht. Die Onboard-Software identifiziert diese schnell als potenzielle Ziele. Es kann sogar eine Empfehlung geben, wie diese Ziele priorisiert werden sollen, und diese Informationen dann dem Piloten präsentieren, um zu entscheiden, was als nächstes zu tun ist.

Wenn man sich an Verteidigungskonventionen hält, besteht beim Militär eindeutig ein Appetit auf mehr solcher Systeme, insbesondere wenn sie mit Robotern gekoppelt werden können. Die US-Firma Ghost Robotics stellt Roboterhunde oder vierbeinige Roboter her, wie die Industrie sie nennt. Sie werden nicht nur als Überwachungsgeräte angepriesen, um Patrouillen bei der Erkundung potenziell feindlicher Gebiete zu helfen, sondern auch als Tötungsmaschinen.

Auf der Jahreskonferenz 2021 der Association of the United States Army im vergangenen Oktober zeigte Ghost Robotics ein Quadrupedal mit einer an der Spitze festgeschnallten Waffe. Die Waffe wird von einer anderen US-Firma, Sword Defense Systems, hergestellt und heißt Special Purpose Unmanned Rifle (Spur). Auf der Sword Defense Systems-Website, Spur soll „die Zukunft unbemannter Waffensysteme sein, und diese Zukunft ist jetzt“.

In Großbritannien erprobt die Royal Navy derzeit ein autonomes U-Boot namens Manta. Das neun Meter lange unbemannte Fahrzeug soll Sonar, Kameras, Kommunikations- und Störgeräte tragen. Unterdessen befinden sich britische Truppen derzeit in der Mojave-Wüste und nehmen mit ihren amerikanischen Kollegen an Kriegsspielen teil. Bekannt als Projekt KonvergenzEin Schwerpunkt der Übung liegt auf dem Einsatz von Drohnen, anderen Roboterfahrzeugen und künstlicher Intelligenz, um „dazu beizutragen, die britische Armee auf dem Schlachtfeld tödlicher zu machen“.

Doch selbst in den ausgeklügeltsten aktuellen Systemen sind Menschen immer an der Entscheidungsfindung beteiligt. Es gibt zwei Beteiligungsebenen: Ein „In-the-Loop“-System bedeutet, dass Computer mögliche Ziele auswählen und sie einem menschlichen Bediener präsentieren, der dann entscheidet, was zu tun ist. Bei einem „On-the-Loop“-System teilt der Computer dem menschlichen Bediener jedoch mit, welche Ziele er zuerst herauszunehmen empfiehlt. Der Mensch kann den Computer immer übersteuern, aber die Maschine ist viel aktiver bei der Entscheidungsfindung. Das Rubikon, das überschritten werden muss, ist dort, wo das System vollständig automatisiert ist und seine eigenen Ziele ohne menschliches Eingreifen auswählt und verfolgt.

„Hoffentlich kommen wir nie so weit“, sagt Martin. „Wenn Sie die Entscheidungsfindung an autonome Systeme übergeben, verlieren Sie die Kontrolle, und wer sagt, dass das System nicht entscheiden wird, dass das Beste für die Kriegsführung nicht die Entfernung der eigenen Führung ist?“ Es ist ein Albtraumszenario, das die Bilder des Films heraufbeschwört Der Terminatorin dem künstlich intelligente Roboter beschließen, einen Krieg zu führen, um die Menschheit zu eliminieren.

Feras Batarseh ist Associate Professor an der Virginia Tech University und Co-Autor von KI-Zusicherung: Auf dem Weg zu einer vertrauenswürdigen, erklärbaren, sicheren und ethischen KI (Elsevier). Obwohl er glaubt, dass vollständig autonome Systeme noch in weiter Ferne liegen, warnt er davor, dass künstliche Intelligenz ein gefährliches Entwicklungsniveau erreicht.

„Die Technologie befindet sich an einem Punkt, an dem sie nicht intelligent genug ist, um vollständig vertrauenswürdig zu sein, aber auch nicht so dumm, dass ein Mensch automatisch weiß, dass er die Kontrolle behalten sollte“, sagt er.

Mit anderen Worten, ein Soldat, der derzeit auf ein KI-System vertraut, kann sich selbst einer größeren Gefahr aussetzen, weil die aktuelle KI-Generation versagt, wenn sie auf Situationen stößt, deren Interpretation ihr nicht explizit beigebracht wurde. Forscher bezeichnen unerwartete Situationen oder Ereignisse als Ausreißer, und der Krieg erhöht ihre Zahl enorm.

„Im Krieg passieren ständig unerwartete Dinge. Ausreißer sind der Name des Spiels und wir wissen, dass aktuelle KIs mit Ausreißern keine gute Arbeit leisten“, sagt Batarseh.

Selbst wenn wir dieses Problem lösen, gibt es immer noch enorme ethische Probleme, mit denen wir uns auseinandersetzen müssen. Wie entscheiden Sie zum Beispiel, ob eine KI die richtige Entscheidung getroffen hat, als sie die Entscheidung getroffen hat, zu töten? Es ist ähnlich wie die sog Trolley-Problem die derzeit die Entwicklung automatisierter Fahrzeuge hemmt. Es gibt viele Gesichter, aber im Wesentlichen läuft es darauf hinaus, zu fragen, ob es ethisch richtig ist, einen bevorstehenden Unfall zuzulassen, bei dem eine Reihe von Menschen getötet werden könnten, oder Maßnahmen zu ergreifen, die diese Menschen retten, aber das Risiko eingehen, eine geringere Anzahl anderer zu töten Personen. Solche Fragen nehmen eine ganz neue Ebene an, wenn das betreffende System tatsächlich zum Töten programmiert ist.

Sorin Matei von der Purdue University, Indiana, glaubt, dass ein Schritt in Richtung einer Lösung darin bestünde, jeden KI-Krieger mit einem zu programmieren Gefühl der eigenen Verletzlichkeit. Der Roboter würde dann seinen Fortbestand wertschätzen und könnte dies auf den Menschen übertragen. Matei deutet sogar an, dass dies zu einer humaneren Kriegsführung führen könnte.

„Wir könnten sie so programmieren, dass sie so sensibel sind, wie es die Genfer Konvention von menschlichen Akteuren verlangt“, sagt er. „Um KIs zu vertrauen, müssen wir ihnen etwas geben, das für sie auf dem Spiel steht.“

Aber selbst der am ethischsten programmierte Killerroboter – oder zivile Roboter in dieser Hinsicht – ist anfällig für eine Sache: Hacking. „Die Sache mit der Entwicklung von Waffensystemen ist, dass Sie ein Waffensystem entwickeln und gleichzeitig jemand versucht, dem entgegenzuwirken“, sagt Ripley.

In Anbetracht dessen wäre eine Streitmacht hackbarer Roboterkrieger das offensichtlichste Ziel für einen Cyberangriff durch einen Feind, der sie gegen ihre Schöpfer aufbringen und alle Ethik aus ihren Mikrochip-Erinnerungen löschen könnte. Die Folgen könnten verheerend sein. Dennoch scheint es, dass Hersteller und Rüstungsunternehmen stark in diese Richtung drängen.

Um eine sinnvolle Kontrolle über solch schreckliche Waffen zu erreichen, schlägt Martin vor, sollten wir die Militärgeschichte im Auge behalten.

„Wenn Sie sich andere Waffensysteme ansehen, vor denen die Menschen wirklich Angst haben – sagen wir nukleare, chemische, biologische –, liegt der Grund dafür, dass wir Rüstungskontrollvereinbarungen darüber erhalten haben, nicht darin, dass wir ihre Entwicklung frühzeitig gestoppt haben, sondern weil die Ihre Entwicklung wurde während des Wettrüstens so beängstigend, dass alle sagten: OK, gut, lass uns darüber reden“, sagt Martin.

Bis dieser Tag kommt, stehen sicher besorgniserregende Zeiten bevor, da Drohnen, Roboter und andere unbemannte Waffen zunehmend ihren Weg auf die Schlachtfelder der Welt finden.