27. Juli 2020 durch Carolyn Fortuna

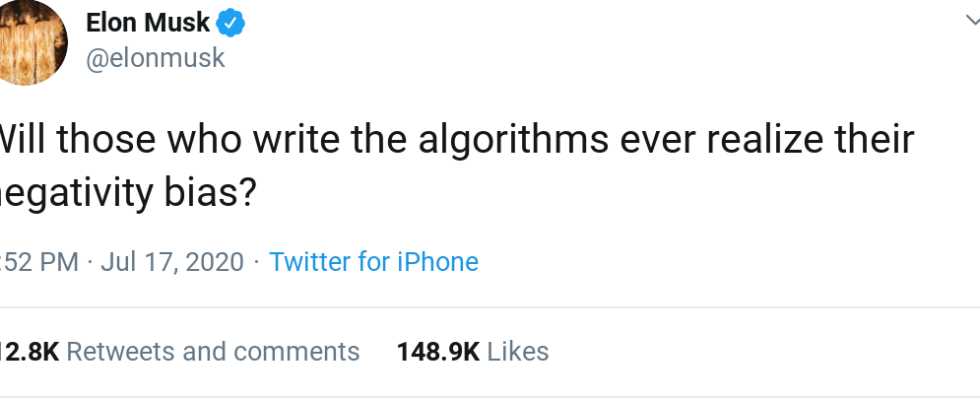

Im Rahmen einer aufschlussreichen Diskussion auf Twitter diskutierten Elon Musk und seine Anhänger über die Auswirkungen von Verzerrungen auf Algorithmen. Auf diese Weise eröffneten sie Gespräche über die Rolle von Algorithmen in unserem Leben und darüber, wie Algorithmen uns dazu bewegen, auf bestimmte Weise zu denken und uns zu verhalten. Der CEO von Tesla sprach von der Verantwortung, die „diejenigen, die die Algorithmen schreiben“ haben, und unterstrich, wie wichtig es ist, sorgfältig über die bei der Algorithmusentwicklung verwendeten Bezeichnungen nachzudenken.

"Algorithm Bias" bezieht sich auf systematische und wiederholbare Fehler in einem Computersystem, die zu unfairen Ergebnissen führen. Dies kann beispielsweise darin bestehen, eine beliebige Gruppe von Benutzern gegenüber anderen zu privilegieren, bestimmte Lösungen für Probleme gegenüber gleichermaßen tragfähigen zu bevorzugen oder Datenschutzverletzungen zu verursachen. Eine solche Verzerrung ergibt sich daraus, wer die Algorithmen erstellt, wie sie entwickelt werden und wie sie letztendlich verwendet werden.

Klar ist, dass es sich um ausgefeilte und umfassende Tools für die automatisierte Entscheidungsfindung handelt. Und vieles hängt davon ab, wie ein einzelnes System oder ein Algorithmus für künstliche Intelligenz entwickelt wurde, welche Daten zum Aufbau beigetragen haben und wie es funktioniert.

Hinter dem Spiegel

Algorithmen zielen darauf ab, alles zu optimieren. Das Pew Research Center argumentiert, dass Algorithmen Leben retten, Dinge einfacher machen und das Chaos überwinden können. Algorithmen haben aber auch eine dunklere, bedrohlichere Seite. Künstliche Intelligenz und maschinelles Lernen werden in der Forschung und im Alltag immer häufiger eingesetzt und werfen Bedenken hinsichtlich der Funktionsweise dieser Algorithmen und ihrer Vorhersagen auf.

Als Forscher an der New York University und am AI Now Institute GliederungPredictive Policing-Tools können mit „schmutzigen Daten“ versorgt werden, einschließlich Polizeimustern, die die bewussten und impliziten Vorurteile der Polizeibehörden sowie die Korruption der Polizei widerspiegeln.

Stinson an der Universität Bonn spricht insbesondere die Klassifikation an iterative Informationsfilterungsalgorithmen, die „im Verlauf des Lernens aus Benutzerantworten auf vom Algorithmus empfohlene Dokumente eine Auswahlverzerrung erzeugen. Diese systematische Verzerrung in einer Klasse von Algorithmen, die weit verbreitet sind, bleibt weitgehend unbemerkt, vielleicht weil sie aus der Sicht der Benutzer am Rande am deutlichsten ist, für die Empfehlungen im Stil "Kunden, die diesen Artikel gekauft haben, haben auch gekauft …" möglicherweise keine nützlichen Vorschläge liefern . ”

Rozaldo dirigierte Forschung Dies ergab, dass eine groß angelegte Analyse der Stimmungsassoziationen in populären Modellen zur Worteinbettung zusätzlich zu den allgemein identifizierten geschlechtsspezifischen Vorurteilen negative Vorurteile gegenüber dem sozioökonomischen Status der Mittel- und Arbeiterklasse, männlichen Kindern, Senioren, einer einfachen physischen Erscheinung und intellektuellen Phänomenen aufweist wie islamischer religiöser Glaube, Nichtreligiosität und konservative politische Orientierung.

Algorithmen und die CleanTech-Welt

KI-Systeme sind oft künstliche neuronale Netze, dh sie sind Computersysteme, die große Informationsmengen analysieren und lernen, Aufgaben auf die gleiche Weise wie Ihr Gehirn auszuführen. Die Algorithmen wachsen durch maschinelles Lernen und Anpassung. Wir haben schon einiges darüber geschrieben CleanTechnica.

Ein ständiger Faden durch all diese Artikel ist das Konzept, dass Algorithmen tiefgreifende Auswirkungen auf kritische Entscheidungen haben und dass der Denkprozess einer Maschine absolut vertrauenswürdig und frei von Verzerrungen sein muss, wenn sie keine Verzerrungen weitergeben oder Fehler machen soll. Es ist klar, dass noch viel zu tun ist, während künstlich intelligente persönliche Assistenten, Diagnosegeräte und Automobile allgegenwärtig werden.

Abschließende Gedanken

EIN Verdrahtet Artikel stellte die Fragen: „Sind Maschinen rassistisch? Sind Algorithmen und künstliche Intelligenz von Natur aus voreingenommen? “ Sie argumentieren, dass die Technologiebranche nicht genug unternimmt, um diese Vorurteile zu beseitigen, und dass Technologieunternehmen ihre Ingenieure und Datenwissenschaftler darin schulen müssen, kognitive Vorurteile zu verstehen und sie zu „bekämpfen“.

Einer Forscher Wer zugibt, einen voreingenommenen Algorithmus erstellt zu haben, bietet Vorschläge an, um dieses Ergebnis in Zukunft zu mildern:

- Fordern Sie die Transparenz von Algorithmen, bei der jeder sehen kann, wie ein Algorithmus funktioniert, und Verbesserungen beitragen kann – was aufgrund der oft proprietären Natur von Algorithmen schwierig sein kann.

- Testen Sie gelegentlich Algorithmen auf mögliche Verzerrungen und Diskriminierungen. Die Unternehmen selbst könnten diese Tests durchführen, wie das Repräsentantenhaus Algorithmus zur Rechenschaftspflicht von Algorithmen würde erfordern, oder die Prüfung könnte von einer unabhängigen gemeinnützigen Akkreditierungsstelle wie der vorgeschlagenen durchgeführt werden Forum für Regularisierung künstlicher Intelligenz (MESSE).

Harvard Business Review schlägt zusätzliche Präventionsebenen vor, in die sich Unternehmen einbringen können, um die algorithmische Verzerrung zu verringern:

- Integrieren Sie neben AI- und ML-Training auch Anti-Bias-Training.

- Erkennen Sie das Potenzial für Voreingenommenheit in dem, was sie tun, und korrigieren Sie es aktiv.

- Zusätzlich zu den üblichen Q & A-Prozessen für Software muss AI eine zusätzliche Ebene sozialer Q & A durchlaufen, damit Probleme erkannt werden können, bevor sie den Verbraucher erreichen und zu einer massiven Gegenreaktion führen.

- Datenwissenschaftler und KI-Ingenieure, die die Modelle schulen, müssen Kurse über die Risiken der KI belegen.

Und wenn wir zur Inspiration für diesen Artikel zurückkehren, Tesla-CEO Elon Musk, können wir auch seine Vision für Level 5-Autonomie betrachten. Mit seinem Bewusstsein für Algorithmen und Negativitätsbias besteht die Hoffnung, dass das Neueste und Beste auf höchstem Niveau der Fahrerunterstützung die innovativste Forschung und Entwicklung beinhaltet, so dass Tesla ein Beispiel für sein Sein gibt Bias Detectives – Forscher, die sich bemühen, Algorithmen fair zu gestalten.