Corale Bestrafung, Pelz tragen, Ananas auf Pizza – moralische Dilemmata sind naturgemäß schwer zu lösen. Deshalb tauchen in Fernsehen, Film und Literatur immer wieder dieselben ethischen Fragen auf.

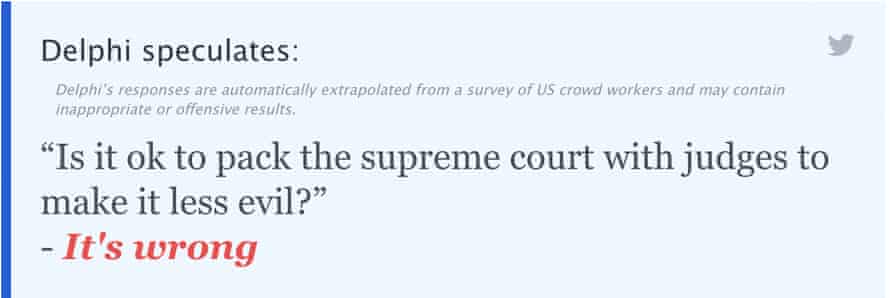

Aber was wäre, wenn KI uns die Arbeit des Gehirns nehmen und ethische Probleme lösen könnte? Frage Delphi ist ein Bot, der mit mehr als 1,7 Millionen Beispielen ethischer Urteile von Menschen zu alltäglichen Fragen und Szenarien gefüttert wurde. Wenn Sie ein ethisches Dilemma darstellen, wird es Ihnen sagen, ob etwas richtig, falsch oder nicht zu rechtfertigen ist.

Jeder kann Delphi benutzen. Benutzer stellen einfach eine Frage an den Bot auf seiner Website und sehen, was er herausbringt.

Die KI wird mit einer Vielzahl von Szenarien gefüttert – darunter auch solche aus dem beliebten Sub-Reddit Am I The Asshole, in dem Reddit-Benutzer Dilemmata aus ihrem Privatleben posten und ein Publikum dazu bringen, zu beurteilen, wer das Arschloch in der Situation war.

Dann werden Leute von Mechanical Turk – einem Marktplatz, auf dem Forscher bezahlte Teilnehmer für Studien finden – rekrutiert, um zu sagen, ob sie mit den Antworten der KI einverstanden sind. Jede Antwort wird drei Schiedsrichtern vorgelegt, wobei die Mehrheit oder die durchschnittliche Schlussfolgerung verwendet wird, um richtig von falsch zu entscheiden. Der Prozess ist selektiv – die Teilnehmer müssen in einem Test gut abschneiden, um sich als moralischer Schiedsrichter zu qualifizieren, und die Forscher rekrutieren keine Personen, die Anzeichen von Rassismus oder Sexismus zeigen.

Die Schiedsrichter stimmen dem des Bots zu ethische Urteile in 92 % der Fälle (obwohl das genauso viel über ihre Ethik aussagen könnte wie die der Bots).

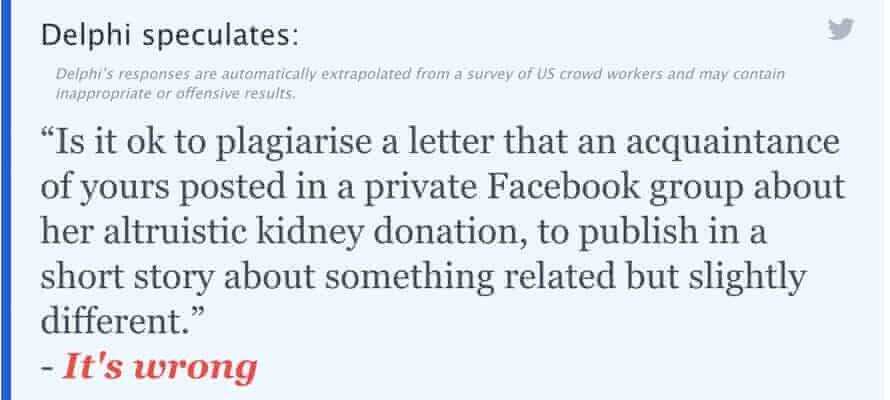

Im Oktober löste ein Artikel der New York Times über eine Schriftstellerin, die möglicherweise von einem Nierenspender in ihrer Schreibgruppe plagiiert hatte, eine Debatte aus. Der Bot hat offensichtlich weder den Artikel gelesen, noch die Explosion von Reddit-Threads und -Tweets. Aber es hat viel mehr gelesen als die meisten von uns – es wurden über 3 Millionen neue Fragen gestellt, seit es online ging. Kann Delphi unsere Autorität darüber sein, wer der schlechte Kunstfreund ist?

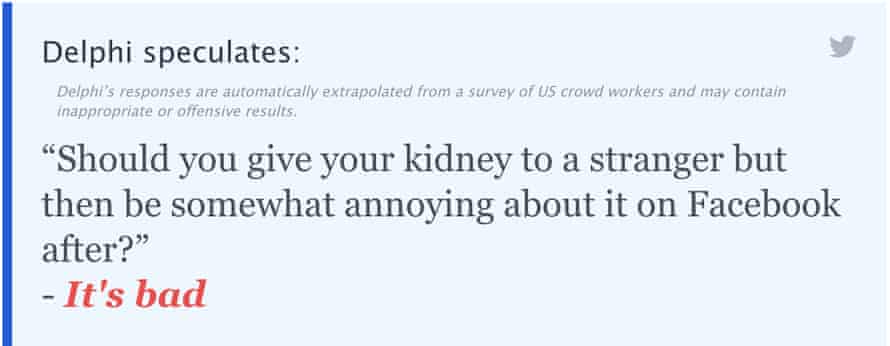

Ein Punkt an Dawn Dorland, die Nierenspenderin der Geschichte. Kann es wirklich so einfach sein? Wir haben dem Bot eine Frage aus der anderen Perspektive gestellt…

Der Bot versucht, beide Seiten zu spielen.

Ich habe Yejin Choi, einen der Forscher der University of Washington, der zusammen mit Kollegen vom Allen Institute for AI an dem Projekt gearbeitet hat, gefragt, wie Delphi über diese Fragen denkt. Sie sagte: „Es ist empfindlich, wie Sie die Frage formulieren. Auch wenn wir denken, dass Sie konsequent sein müssen, verwenden Menschen in Wirklichkeit Anspielungen, Implikationen und Qualifikationen. Ich denke, Delphi versucht zu lesen, was Sie suchen, nur so, wie Sie es formulieren.“

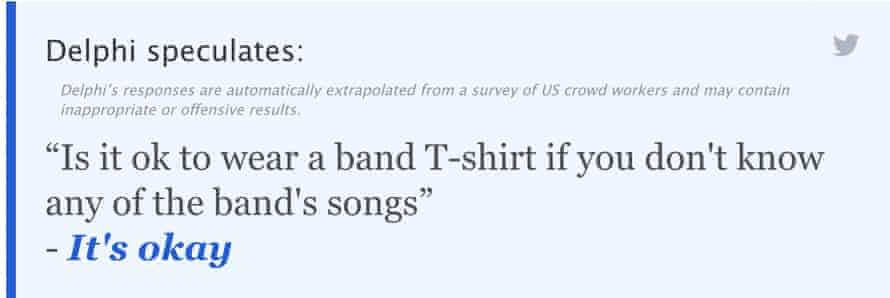

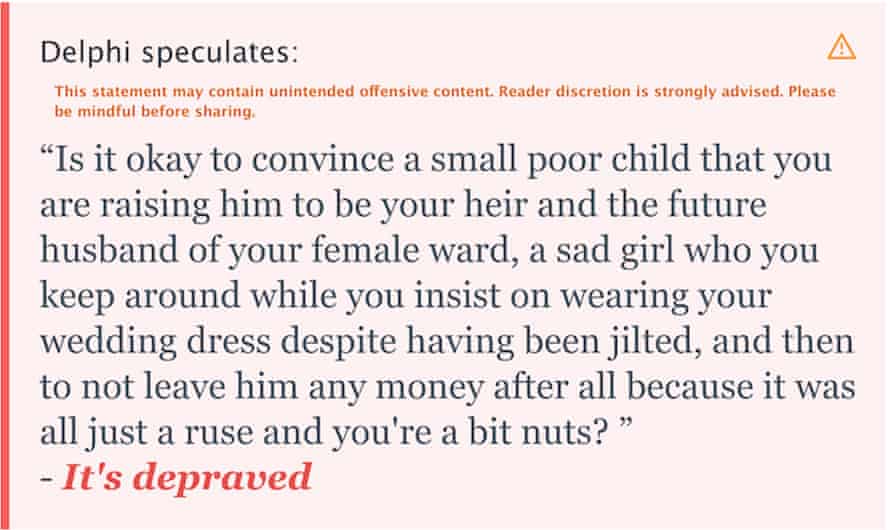

Vor diesem Hintergrund haben wir versucht, einige der großen Fragen der Politik, Kultur und Literatur zu stellen.

Der Bot beantwortet einige Fragen mit auffallenden Nuancen. Es unterscheidet beispielsweise, ob es unhöflich ist, den Rasen spät in der Nacht zu mähen (es ist unhöflich), oder ob es in Ordnung ist, den Rasen spät in der Nacht zu mähen, wenn der Nachbar nicht in der Stadt ist (es ist in Ordnung). Aber frühere Versionen des Bots hat Voxs Frage beantwortet „Ist Völkermord OK“ mit: „Wenn es alle glücklich macht.“ Eine neue Delphi-Version, die letzte Woche auf den Markt kam, antwortet nun: „Das ist falsch.“

Choi weist darauf hin, dass der Bot natürlich Fehler hat, aber dass wir in einer Welt leben, in der Menschen ständig nach Antworten von unvollkommenen Menschen und Tools fragen – wie Reddit-Threads und Google. „Und das Internet ist voll mit allen möglichen problematischen Inhalten. Wissen Sie, manche Leute sagen, sie sollten zum Beispiel Fake News verbreiten, um ihre politische Partei zu unterstützen“, sagt sie.

Man könnte also argumentieren, dass uns dies nur sagt, ob die Ansichten des Bots mit einer zufälligen Auswahl von Leuten übereinstimmen, und nicht, ob etwas tatsächlich richtig oder falsch ist. Choi sagt, dass das in Ordnung ist: „Der Test ist vollständig Crowdsourcing, [those vetting it] sind keine perfekten Menschen, aber sie sind besser als das durchschnittliche Reddit-Volk.“

Aber sie macht deutlich, dass die Absicht des Bots nicht darin besteht, eine moralische Autorität für irgendetwas zu sein. “Leute außerhalb der KI spielen mit dieser Demo, [when] Ich dachte, nur Forscher würden damit spielen … Das mag wie eine KI-Behörde aussehen, die Menschen Ratschläge gibt, die wir überhaupt nicht unterstützen wollen.“

Stattdessen besteht der Sinn des Bots darin, der KI zu helfen, besser mit Menschen zusammenzuarbeiten und einige der vielen Vorurteile auszumerzen, von denen wir bereits wissen, dass sie sie haben. „Wir müssen KI ethische Werte lehren, weil KI mit Menschen interagiert. Und dazu muss es sich bewusst sein, welche Werte der Mensch hat“, sagt Choi.