Sharon Zhou

- Alle in der KI-Branche sind offenbar von den Chips von Nvidia begeistert.

- Alle außer Sharon Zhou.

- Die CEO von Lamini AI hat die GPUs der Konkurrenz von AMD genutzt, um ihr Startup voranzubringen.

Tech-CEOs mit großen Plänen für künstliche Intelligenz verbrachten letztes Jahr viel Zeit damit, nach Nvidia-Chips zu suchen.

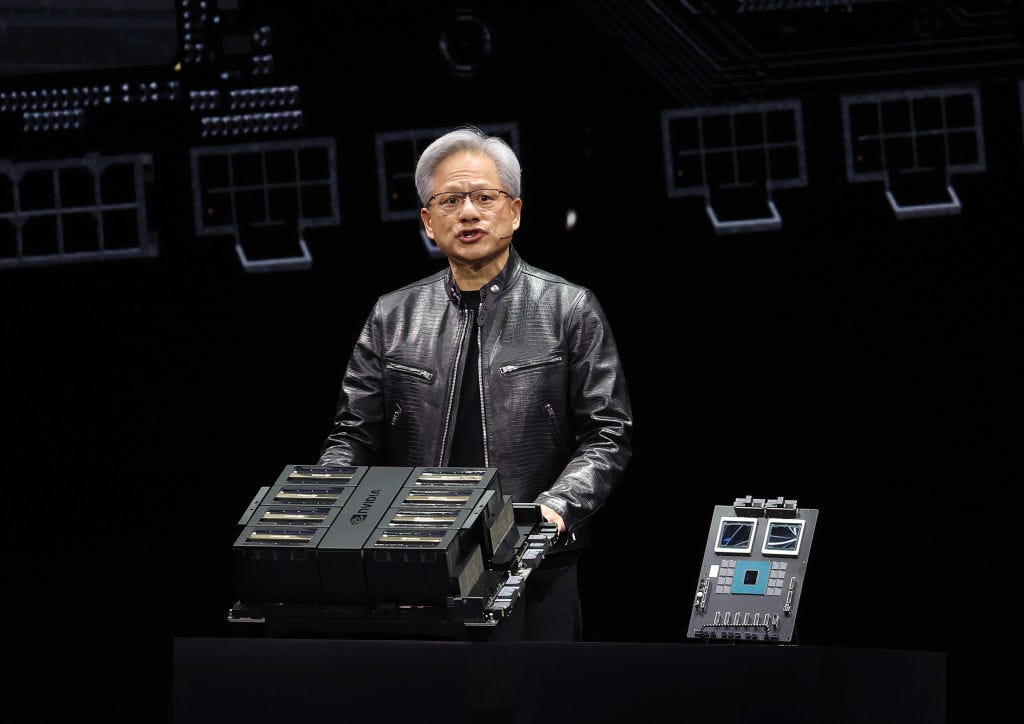

Die Chips des Santa Clara-Riesen, sogenannte GPUs, wurden zum heißesten Objekt des generativen KI-Booms. So mächtige Persönlichkeiten wie Mark Zuckerberg und Sam Altman kämpften darum, sich die Versorgung mit lebenswichtigen Computerressourcen zu sichern, die für den Betrieb von Apps wie ChatGPT erforderlich sind.

Allerdings gibt es eine KI-Chefin, die sich nicht der Gnade von Nvidias Milliardär Jensen Huang und seinem 2,2 Billionen US-Dollar schweren GPU-Imperium ausgeliefert hat. Treffen Sie Sharon Zhou.

Der 30-Jährige hat eine beachtliche Karriere hinter sich.

Sie ist die erste Person, die in Harvard sowohl klassische Philologie als auch Informatik studiert. Sie erhielt einen Ph.D. Er studierte generative KI an der Stanford University bei Andrew Ng, Pionier des maschinellen Lernens, wurde außerordentlicher Professor an der Universität und nahm sich Zeit für Online-Lehre und Angel-Investitionen. Als ob das noch nicht genug wäre, wurde sie auch gebeten, Teil des frühen Gründungsteams von Anthropic zu werden, dem OpenAI-Rivalen, der gerade zusätzliche 2,75 Milliarden US-Dollar von Amazon eingesammelt hat.

Ihre Ambitionen haben sie jedoch in eine etwas andere Richtung geführt, da sie nun ihren eigenen Weg geht, indem sie die Leitung eines eigenen KI-Startups übernimmt.

Wer braucht Nvidia?

Im April letzten Jahres haben Zhou und ihr Mitbegründer Greg Diamos, ansässig in Palo Alto, brachte ihr neues Startup, Lamini AI, aus der Tarnung. Sein Hauptziel bestand darin, eine Plattform anzubieten, die es Unternehmen erleichtert, mit „nur wenigen Codezeilen“ individuelle große Sprachmodelle zu trainieren und zu erstellen.

Das könnte bedeuten, ein Basismodell wie GPT von OpenAI zu übernehmen und es einem Unternehmen einfach zu machen, dieses Modell mit seinen eigenen Daten zu verfeinern. „Wir machen es im Grunde jedem Unternehmen möglich, die OpenAI-Infrastruktur intern zu nutzen“, sagte Zhou.

Eine ebenso interessante Offenbarung kam jedoch Monate später.

Im September gab Zhou bekannt, dass die Plattform von Lamini im vergangenen Jahr maßgeschneiderte LLMs mit Kunden entwickelt hat verwendet ausschließlich GPUs von Nvidias Hauptkonkurrent AMDder Chipriese, der von Huangs Cousine Lisa Su geführt wird.

Das war eine große Sache, wenn man bedenkt, dass fast jeder ausschließlich von H100 besessen zu sein schien – GPUs, deren Nachfrage Nvidia aufgrund von Lieferengpässen nur schwer befriedigen konnte. Laminis Enthüllung kam sogar mit ein Video, in dem Zhou Nvidia neckt über den Mangel.

Wie Zhou jedoch zugibt, war es keine leichte Entscheidung, den Blick von dem abzuwenden, wonach alle in der generativen KI verzweifelt gesucht haben. „Der Entscheidungsprozess war langwierig“, sagte sie. „Es war keine triviale, kleine Angelegenheit.“

Ein paar Dinge haben bei der Entscheidung geholfen. Zum einen trug ihr Mitbegründer Diamos maßgeblich dazu bei, dass man erkannte, dass auch andere GPUs als die von Nvidia einwandfrei funktionieren.

Als ehemaliger Nvidia-Softwarearchitekt verstand Diamos, dass GPU-Hardware zwar entscheidend für die Spitzenleistung von KI-Modellen war, er aber schließlich derjenige war Mitautor einer Arbeit über „Skalierungsgesetze“ Das zeigte die Bedeutung der Rechenleistung – auch Software war wichtig.

Diamos war Zeuge davon und arbeitete an CUDA, der Software, die erstmals in den 2000er Jahren von Nvidia entwickelt wurde. Es macht die Verwendung von KI-Modellen mit GPUs wie dem H100 und dem neuen Blackwell-Chip von Nvidia so einfach wie ein Plug-and-Play-System.

Justin Sullivan/Getty Images

Es wurde also klar, dass es keinen Grund gäbe, nicht mit Nvidia zu konkurrieren, wenn ein anderes Unternehmen ein ähnliches Software-Ökosystem rund um seine GPUs aufbauen könnte. Zu ihrem Glück war AMD laut Zhou nach Rücksprache mit Diamos auf dem Weg, ein Konkurrenzsystem zu entwickeln, das sie schließlich testen würden.

„Greg und ich haben nur an Dingen herumgejammert, es hat also Jahre gedauert, daran zu arbeiten, und als die Prototypen dann funktionierten, dachten wir, lasst uns das noch einmal verdoppeln“, sagte Zhou.

Im weiteren Sinne erkennt Zhou an, dass Unternehmen „sehr begeistert von der Nutzung von LLMs“ sind, viele jedoch möglicherweise nicht darauf warten wollen oder es sich einfach nicht leisten können, darauf zu warten, dass Nvidia genügend GPUs zur Verfügung stellt, um die Nachfrage zu decken.

Dies ist ein weiterer Grund, warum sich AMD für ihre Ambitionen als so wertvoll erwiesen hat. Dank der größeren Verfügbarkeit seiner GPUs war Zhou zuversichtlich, dass Lamini eine „Infrastruktur anbieten könne, die es ermöglicht, diesen rasant steigenden Bedarf“ an LLMs zu decken.

„Das liegt daran, dass Lamini die LLM-Rechenleistung bei 10-facher Leistung voll ausnutzt und eine schnelle Skalierung ohne Lieferengpässe ermöglicht, indem es herstellerunabhängige Rechenoptionen anbietet, d. h. es ist für Kunden nicht erkennbar, Lamini auf Nvidia- und AMD-GPUs auszuführen“, erklärte sie.

Kein Wunder, dass das Unternehmen bereit ist, AMD zu verdoppeln. Im Januar, Zhou hat ein Bild mit X geteilt des MI300X – AMDs neuer Chip, der erstmals im Dezember von CEO Su als „leistungsstärkster Beschleuniger der Welt“ vorgestellt wurde – live in Produktion bei Lamini.

Huang von Nvidia leitet derzeit vielleicht eines der mächtigsten Unternehmen im Silicon Valley, aber die Konkurrenz kommt auf ihn zu. Oder wie Zhou über AMD sagte: „Sie haben ein echtes Pferd in diesem Rennen.“