Hatten Sie jemals Schwierigkeiten, die richtigen Keywords für eine Google-Suche zu finden? Nun, falls du das jemals getan hast, ich weiß genau, wie du dich fühlst. Aber Google hat uns abgedeckt. Es führt eine neue Funktion in Google Lens ein, die Ihnen helfen soll, Dinge zu finden, die Sie nicht einfach beschreiben können, und es heißt Multisearch. berichtet 9to5Google. Es wird in der Beta-Version für US-Benutzer eingeführt und ermöglicht es Ihnen, ein Foto von etwas zu machen und eine Frage dazu zu stellen.

Google Lens Multisearch Beta kommt jetzt in die USA, sowohl für Android als auch für iOS

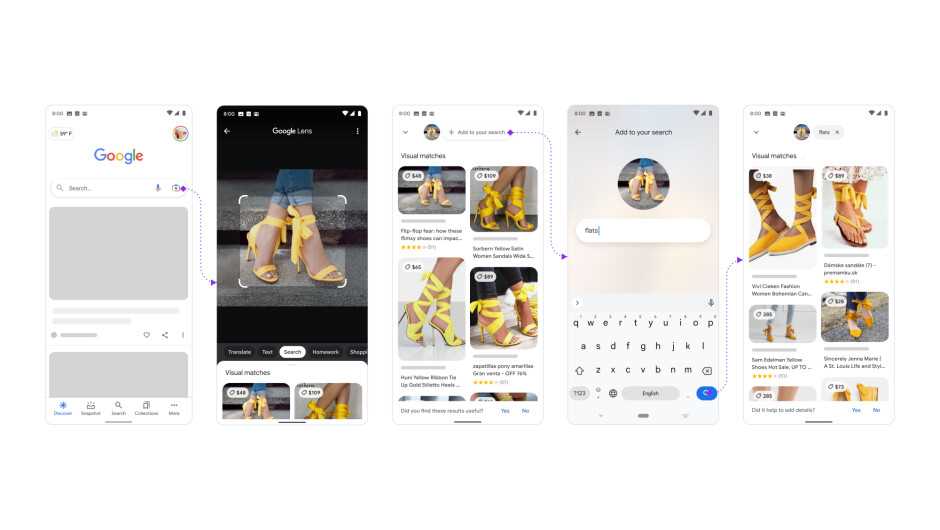

Bereits im September letzten Jahres hielt Google seine auf die Suche ausgerichtete Keynote ab, und eines der coolsten Dinge, die der Tech-Riese aus Mountain View während der Veranstaltung ankündigte, war ein großes Upgrade von Google Lens. Die Multisearch-Funktion ist jetzt endlich für Betatester auf Android und iOS verfügbar. Multisearch ist so ziemlich eine völlig neue Art, in Google zu suchen, und es konzentriert sich darauf, Ihnen bei den Dingen zu helfen, für die Sie nicht alle Worte haben, um sie zu beschreiben. Im Grunde nehmen Sie mit Google Lens ein Foto von dem ach so unbeschreiblichen Ding auf (oder Sie können sogar ein vorhandenes importieren), wischen dann im Ergebnisbereich nach oben und tippen auf die neue Schaltfläche „Zu Ihrer Suche hinzufügen“, die sich befindet oben.

Über die Schaltfläche können Sie eine Frage zum Objekt eingeben oder Ihre Suche nach Farbe, Marke oder einem anderen visuellen Attribut verfeinern. Ja, aber was bedeutet das genau? Nun, hier sind einige Beispiele.

Sie haben ein Foto oder einen Screenshot von einem coolen orangefarbenen Kleid gemacht, um es Ihrer Freundin zu schenken, möchten aber sehen, ob es in einer anderen Farbe erhältlich ist: Fügen Sie einfach “grün” zur Suche hinzu und die Ergebnisse sollten Ihnen das Kleid zeigen in grün (wenn es natürlich eine grüne Option gibt).

Ein weiteres Beispiel ist ein Foto mit Ihrer Essgruppe, mit der Suchanfrage „Couchtisch“, und Sie können einen passenden oder ähnlichen Tisch finden.

Oder … stell dir vor, deine Mutter hat dir gesagt, dass du dich um ihre Pflanze kümmern sollst, wenn sie auf Reisen ist. Ja, wir wollen es nicht töten, aber was ist, wenn Sie nicht einmal wissen, um welche Pflanze es sich handelt? Ganz einfach: fotografiere es und füge die Abfrage „Pflegehinweise“ hinzu, und Google Lens erspart dir die Peinlichkeit.

Bisher liegen die Highlights in den Bereichen Mode und Wohnkultur, und derzeit beziehen sich die besten Ergebnisse von Google Lens Multisearch auf Shopping-Suchanfragen, aber wir können leicht sehen, wie diese Funktion wächst und in Zukunft noch nützlicher wird. Das Beispiel von Google mit einer Rosmarinpflanze zeigt tatsächlich, dass man nicht erst eine Suche durchführen muss, um die Pflanze zu identifizieren, und dann eine zweite, um Pflegehinweise zu erhalten: Die beiden Dinge sind vereint.

KI und insbesondere Fortschritte in der KI machen Google Lens Multisearch möglich. Komplexere Abfragen kann es derzeit jedoch nicht verarbeiten, da es noch nicht das Multitask Unified Model verwendet. Falls Sie sich fragen, was das ist, das Multitask Unified Model oder MUM wurde während einer Demo vorgestellt. Es erlaubte Ihnen, ein Foto von kaputten Fahrradschaltungen zu machen und Anweisungen für die Reparatur zu erhalten.

Die Multisearch-Funktion wird jetzt offiziell in der Beta-Version für die USA eingeführt und ist über die Google-App auf Android- und iOS-Geräten zugänglich.

Der Search Director des Unternehmens, Lou Wang, erklärte, dass dies darauf abzielen soll, den Menschen zu helfen, Fragen natürlicher zu verstehen. In Zukunft, so Wang, werde Multisearch auf Videos, mehr Bilder im Allgemeinen und sogar „die Art von Antworten, die man in einer traditionellen Google-Textsuche finden könnte“ ausgeweitet (via TheVerge).